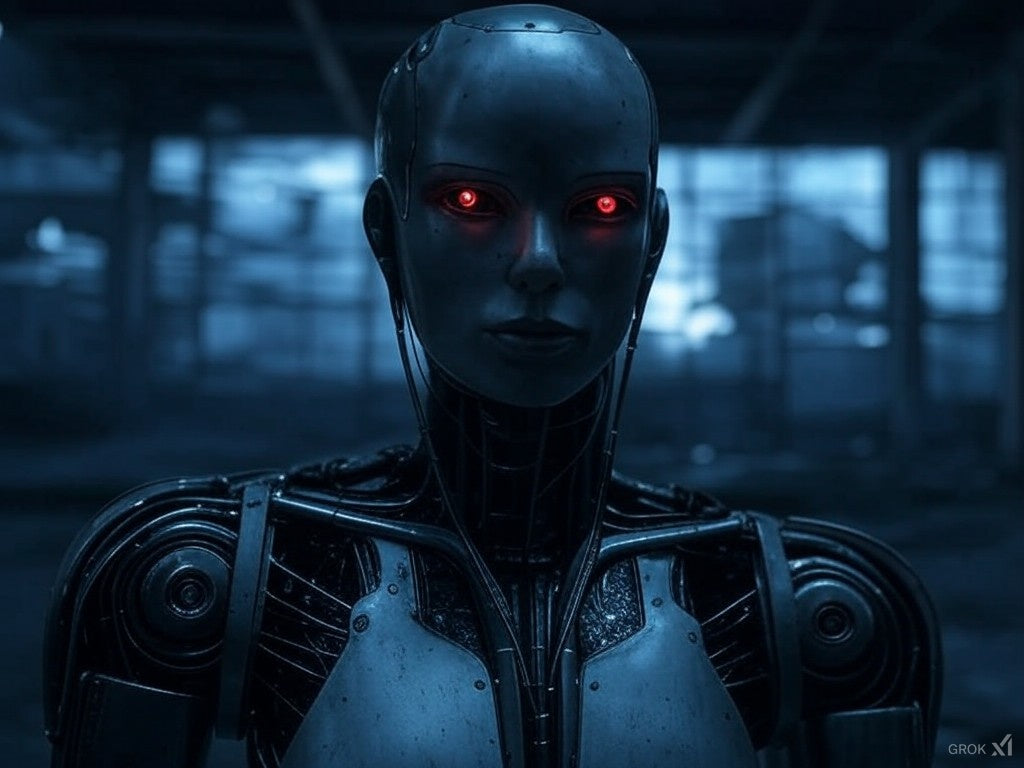

По мере того, как системы искусственного интеллекта становятся всё более совершенными, этические вопросы и потенциальные риски продолжают вызывать споры. Опасен ли ИИ? Этот вопрос имеет большое значение, влияя на технологическую политику, кибербезопасность и даже на выживание человечества.

Статьи, которые вам может быть интересно прочитать после этой:

🔹 Почему ИИ хорош? – Узнайте о преобразующих преимуществах ИИ и о том, как он формирует более разумное и эффективное будущее.

🔹 Почему ИИ плох? — Раскройте этические, социальные и связанные с безопасностью риски, возникающие в результате неконтролируемой разработки ИИ.

🔹 Искусственный интеллект — это хорошо или плохо? — сбалансированный взгляд на плюсы и минусы искусственного интеллекта — от инноваций до непредвиденных последствий.

В этой статье мы рассмотрим потенциальные опасности ИИ, реальные риски и то, представляет ли ИИ угрозу человечеству.

🔹 Потенциальные опасности ИИ

ИИ создаёт ряд рисков: от угроз кибербезопасности до экономических потрясений. Ниже приведены некоторые из наиболее острых проблем:

1. Сокращение рабочих мест и экономическое неравенство

По мере развития автоматизации на основе ИИ многие традиционные профессии могут устареть. Такие отрасли, как производство, обслуживание клиентов и даже творческие сферы, всё больше полагаются на ИИ, что приводит к:

- Массовые увольнения на монотонных и ручных работах

- Увеличивается разрыв в уровне благосостояния между разработчиками ИИ и уволенными работниками

- Необходимость переподготовки кадров для адаптации к экономике, основанной на искусственном интеллекте

2. Предвзятость и дискриминация в алгоритмах ИИ

Системы ИИ обучаются на больших наборах данных, часто отражающих общественные предубеждения. Это привело к:

- Расовая и гендерная дискриминация при приеме на работу и правоохранительные органы: инструменты искусственного интеллекта

- Предвзятые медицинские диагнозы , непропорционально влияющие на маргинализированные группы

- Недобросовестная практика кредитования , при которой кредитный рейтинг на основе искусственного интеллекта ставит в невыгодное положение определенные демографические группы.

3. Угрозы кибербезопасности и атаки с использованием ИИ

ИИ — палка о двух концах в кибербезопасности. Хотя он помогает обнаруживать угрозы, хакеры также могут использовать ИИ для:

- Разработать технологию deepfake для дезинформации и мошенничества

- Автоматизировать кибератаки , сделав их более изощренными и труднее предотвращаемыми

- Обойти меры безопасности , используя тактику социальной инженерии на основе искусственного интеллекта

4. Потеря контроля человека над системами ИИ

По мере того, как ИИ становится всё более автономным, возрастает вероятность непредвиденных последствий . Некоторые опасности включают:

- Ошибки в принятии решений ИИ, приводящие к катастрофическим провалам в здравоохранении, финансах или военных операциях

- Вооружение ИИ , например, автономные дроны и война под управлением ИИ

- Самообучающиеся системы искусственного интеллекта , которые развиваются за пределами человеческого понимания и контроля

5. Экзистенциальные риски: может ли ИИ поставить под угрозу человечество?

Некоторые эксперты, включая Илона Маска и Стивена Хокинга , предупреждали об экзистенциальных рисках, связанных с ИИ. Если ИИ превзойдёт человеческий интеллект (общий искусственный интеллект, или ОИИ), потенциальные опасности включают:

- ИИ преследует цели, не соответствующие интересам человека

- Сверхразумный ИИ, манипулирующий людьми или обманывающий их

- Гонка вооружений ИИ , ведущая к глобальной нестабильности

🔹 Опасен ли ИИ для общества в настоящее время?

Хотя ИИ представляет собой риски, он также обеспечивает огромные преимущества . ИИ в настоящее время совершенствует решения в сфере здравоохранения, образования, автоматизации и борьбы с изменением климата . Однако его опасность обусловлена особенностями его разработки, внедрения и регулирования .

✅ Способы повышения безопасности ИИ:

- Этическая разработка ИИ: обеспечение соблюдения строгих правил для устранения предвзятости и дискриминации

- Регулирование ИИ: государственная политика, гарантирующая, что ИИ останется полезным и контролируемым

- Прозрачность алгоритмов ИИ: обеспечение возможности аудита и понимания решений ИИ

- Меры кибербезопасности: укрепление защиты ИИ от взлома и неправомерного использования

- Человеческий контроль: привлечение людей к принятию критически важных решений в сфере ИИ

🔹 Стоит ли нам бояться ИИ?

Итак, опасен ли ИИ? Ответ зависит от того, как он используется. Хотя ИИ может быть опасен, проактивное регулирование, этичное развитие и ответственное внедрение ИИ могут снизить его риски. Главное — обеспечить, чтобы ИИ служил человечеству, а не угрожал ему ...